Неколкумина научници Сингапурќани и нивни колеги од Хонг Конг користеле податоци од магнетна резонанца кои ги пуштиле во ВИ модел за трансформација на „текст во слика“ за на крајот да создадат модел „MinD-Video“ за генерирање видео содржини со висок квалитет од читања на мозокот.

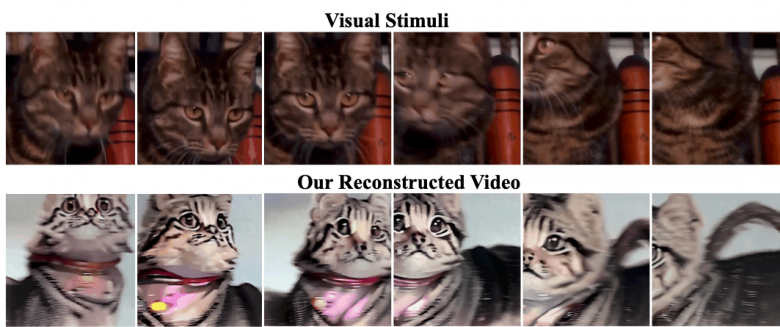

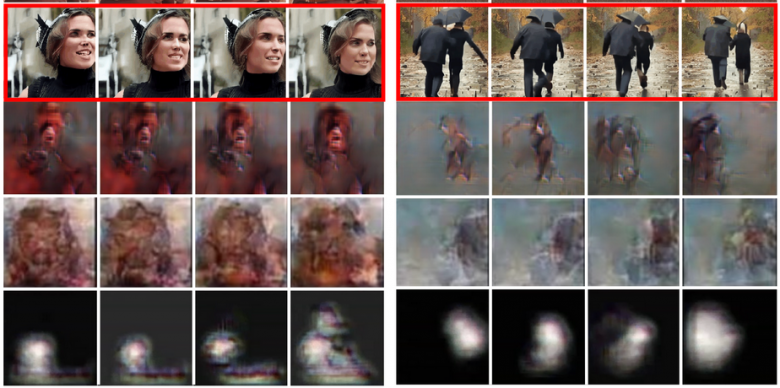

Нивната веб демонстрација на експериментот покажува паралела помеѓу видеата што им биле прикажани на субјектите и видеата генерирани од вештачката интелигенција создадени врз основа на нивната мозочна активност. Разликите помеѓу двете видеа се мали а ова е само почеток на читање на мислите.

За да го обучат системот, истражувачите користеле јавно достапна база на видеа и мозочни читања на fMRI од испитаниците кои ги гледале. Системот се состои од обучен fMRI енкодер и фино подесена верзија на Stable Diffusion, широко користен модел за ВИ генерирање слики.

Освен со мачиња, биле „реконструирани“ и поинакви видеа и секогаш се добивале висококвалитетни реконструкции, во поглед на движењата, динамиката и колоритот на содржините.

Сè на сè, во оваа фаза се добиваат видеа со точност од 85%.